Bu öğrenmede kendi ortamını algılayan ve ortamında hareket yapan özerk bir etmenin, amacını gerçekleştirmek için en uygun hareketleri yapmayı nasıl öğrenebileceği sorusuna cevap verilir [1]. Robotik, oyun programlama, hastalık tanı ve teşhisi, otomasyon gibi sistemlerde yaygın olarak kullanılmaktadır.

Takviyeli öğrenme ortamında etmendeki bir hareketinin karşılığı olarak eğitici veya yazılım, yeni durumun istem durumunu belirtmek için bir ödül veya ceza ile etmeni takviye işlemi gerçekleştirir. Böylece bu sistemde, amaca ulaşmak için gerçekleştirilebilecek en iyi eylem seçilmeye çalışır [2].

Takviyeli öğrenme ile problemleri çözmek için iki ana yöntem vardır: Bunlardan ilki, ortamı iyiye götüreni bulmak için eğitim uzayında bir arama yapmak, ikincisi ise faydalı hareketi tahmin etmek için istatistik ve dinamik programlama yöntemlerini kullanmaktır [3].

Takviyeli öğrenmenin amacı optimal politikayı bulmaktır. Optimal politika, etmenin problemi optimal yönden çözmesini ve sonuca ulaşmasını sağlar. Böylece etmen hedefi olan en yüksek ödül değerine de ulaşmış olur. Optimal politika rasgele bir st durumundan başlanmış indirgenmiş toplam ödül miktarının maksimum değeri şeklinde ifade edilebilir. Takviyeli öğrenmede etmenin amacına ulaşması için eğitmen veya yazılım tarafından belirlenen amaç ve ödüller büyük önem taşımaktadır. Bu sebeple takviyeli öğrenme metoduyla tasarlanan sistemlerde amaç ve ödüllendirmenin, etmenin başarısını etkilediği ve ne kadar önemli olduğu görülmektedir [4].

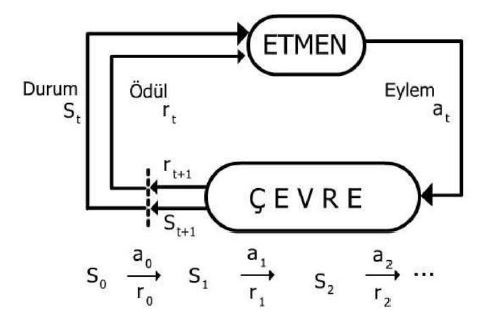

Burada П davranış politikası, V ise değer fonksiyonu olup 𝑠𝑡 ise t anındaki davranış durumudur.Takviyeli öğrenmenin denetimli öğrenmeden en belirgin farkı, etmenin tahminleri için etmene sadece bir kısım geribildirim verilir. Ayrıca buradaki tahminler kontrol edilen sistemin gelecekteki durumu üzerinde uzun vadeli etkili olabilir. Böylece zaman önemli bir faktör olmaktadır [5]. Takviyeli öğrenme sistemi Şekilde gösterilmiştir [4].

|

| Takviyeli öğrenme sistemi |

Bir takviyeli öğrenme sisteminde etmen ve çevre dışında biri opsiyonel olmak üzere dört unsur bulunur [6]:

- Politika (policy)

- Ödül (reward signal)

- Değer/Durum Değeri (value function)

- Çevre modeli (model)

Politika; etmenin içinde bulunduğu durumda alabileceği aksiyonu belirler. Ödül; etmenin gerçekleştirmiş olduğu bir aksiyona karşılık çevreden aldığı puandır. Durum değeri; etmenin içinde bulunduğu durumdan ve o durumu takip eden diğer durumlardan bekleyebileceği ödüllerin toplamıdır. Model; isteğe bağlı olarak sisteme dâhil edilen bir unsurdur [6].

Zamansal fark öğrenimi (temporal difference learning — TD learning): Zamansal fark öğrenmenin açıklanmasından önce, temel bir değer fonksiyonları anlayışı ile başlamak gerekir. Değer fonksiyonları, belirli bir eylemin belirli bir durumda ne kadar iyi olacağını tahmin eden durum-eylem çifti işlevleridir veya bu eylemin geri dönüşünün ne olacağını tahmin eder. Değer fonksiyonları gösterimi [7]:

Vπ(s) — π politikasındaki s durumunun değeri.

Qπ(s,a) — π politikasındaki s durumunun, a hareketini gerçekleştirme değeri (Q değeri).

Burada bulunan problem, belirli bir politika için bu değer işlevlerini tahmin etmektir. Bu değer işlevlerini tahmin etmenin sebebi, verilen durumda gerçekleştikten sonra, mümkün olan en iyi toplam ödülü sağlayacak bir işlemi, doğru bir şekilde seçmek için kullanılabilecek olmalarıdır [7].

TD öğrenim yöntemi, ortamın dinamikleri modeli olmadan doğrudan ham deneyimlerden öğrenebilen bir takviyeli öğrenme algoritmasıdır. Bu yöntemde, nihai bir sonuç beklemeden, diğer öğrenilmiş tahminlere dayanan tahminler kısmen güncellenir (önyükleme yapılır) [3]. TD öğrenim yönteminde tahminler öğrenme sürecinde hedef olarak kullanılır. Modelsiz bir öğrenme algoritması olan TD öğrenimin iki önemli özelliği vardır:

- Model dinamiğinin önceden bilinmesini gerektirmez.

- Epizodik olmayan görevler için de uygulanabilir.

TD öğrenim değer fonksiyonlarını tahmin etmek için kullanılabilir. Değer fonksiyonları tahmin edilmeksizin hesaplanacak olsaydı, herhangi bir durum-eylem çifti değerleri güncellenmeden önce, son ödülün alınmasını beklemek gerekirdi. Nihai ödül alındıktan sonra, nihai duruma ulaşmak için alınan yolun geri dönülmesi ve her değerin buna göre güncellenmesi gerekirdi. Bunun yerine TD öğrenim yöntemleriyle, her bir durumda nihai ödülün bir tahmini hesaplanır ve durumun her adımı için durum-eylem değeri güncellenir. Bu hesap şöyle ifade edilir [7]:

Burada: 𝑟𝑡+1, t + 1 zamanında gözlenen ödüldür. 𝛾 ise 0 ile 1 arasında bir indirim oranı değeridir. Değer ne kadar yüksek olursa, o kadar az indirim yapılır.

TD öğrenim yöntemi “önyükleme” yöntemi olarak adlandırılır, çünkü değer, nihai bir ödül değil, mevcut bir tahmin kullanılarak kısmen güncellenir. TD öğrenme “Politikalı” ve “Politika Dışı” Öğrenme olarak iki şekilde düzenlenebilir. Politikalı öğrenmede yöntemler karar vermek için kullanılan politikanın değerini öğrenir. Değer işlevleri, bazı politikaların belirlediği eylemleri gerçekleştirmenin sonuçları kullanılarak güncellenir. Bu politikalar genellikle yumuşak (her zaman politikaya bir keşif unsuru olduğunu garanti eder) ve determinist değildir. Politika katı değildir ve her zaman en fazla ödülü veren eylemi seçer. Soft, greedy ve softmax olmak üzere üç çeşit sıklıkla kullanılan politika vardır. Politika Dışı yöntemler, davranış ve tahmin için farklı politikalar öğrenebilir. Davranış politikası genellikle yumuşaktır. Politika dışı algoritmalar, aslında denenmemiş olan varsayımsal eylemleri kullanarak tahmini değer işlevlerini güncelleyebilir. Politika dışı algoritmalar araştırmayı kontrolden ayırabilir ve politika içi algoritmalar yapamaz. Politika dışı bir yöntem kullanılarak eğitilmiş bir ajan, öğrenme aşamasında mutlaka göstermemesi gereken öğrenme taktikleri ile sonuçlanabilir.

Qöğrenme: En sık kullanılan takviyeli öğrenme algoritmalarındandır. Q öğrenme çevre hakkında bilgi sahibi olunamayan ortamlarda çevrimiçi olarak öğrenebilen bir algoritmadır. Rasgele bir ortam içinde etmene, optimal politikayı nasıl öğrenebileceği gösterilir. Etmenin optimal politikayı doğrudan öğrenmesi zordur. Çünkü etmen için kullanabileceği eğitim verileri bulunmamaktadır. Etmen için kullanılabilir eğitim verisi sadece anlık ödüllerdir. Bu eğitim verilerini kullanarak sayısal bir değerlendirme fonksiyonunu öğrenmek ve daha sonra bu fonksiyon yardımıyla optimal politikayı belirlemek daha kolaydır [4].

TD öğrenme için politika dışı bir algoritmadır. Q öğrenme algoritmasının temel amacı bir sonraki hareketleri inceleyip yapacağı hareketlere göre kazanacağı ödülü görmek ve bu ödülü en çok hale getirecek şekilde hareket etmektir. Bu algoritmada bir nevi, ajanın geleceğe dair plan kurması beklenmektedir. Bu algoritma labirent ve arama gibi problemlere sıklıkla uygulanmaktadır.

Algoritmanın temel olarak iki matris üstüne kurulmuştur. İlk matris Reward (Ödül) matrisi, diğeri ise State (durum) matrisidir. Belirli bir tekrar süresince hareket eden robot bu hareketler sırasında R matrisindeki değerler yoluyla S matrisini tamamlar. Tüm tekrarlar sonucunda oluşan S matrisinin son değerleri ise optimal sonucu gösterir.

Q öğrenme, sonlu durumlu Markov Karar Süreci olarak modellenebilen alanlara kolaylıkla uygulanabilecek modelden bağımsız bir Takviyeli Öğrenme algoritmasıdır. Takviyeli öğrenme problemleri matematiksel olarak Markov karar süreçleri gibi modellenebilirler. Markov karar süreci şu parametrelere bağlı olarak tanımlanır [8].

- Sonlu durumlar kümesi, S

- Hareketler kümesi, A

- Bir ödül fonksiyonu, R: S x A → R

- Durum geçiş fonksiyonu, T: S x A → π(S)

Burada π(S), S kümesi üzerinde bir olasılık dağılımı olarak tanımlanabilir. Durum geçiş fonksiyonu, etmenin o andaki durum ve hareketinin bir fonksiyonu olarak, bir olasılıkla ortamın sonraki durumunu belirler. Ödül fonksiyonu ise anlık ödülleri verir. Bu özellik Markov Özelliği olarak bilinir. Buna göre, geçmiş durum, hareket ve takviye arasında bir bağımlılık söz konusu değildir. Bu yüzden, Markov karar süreci ortamın sadece bir adım için dinamiğini tanımlar [8].

Q öğrenme prosedürü şöyle sıralanabilir:

- Q-değerleri tablosunu (Q (s, a)) başlat.

- Mevcut durumu gözlemle, s.

- Eylem seçimi politikalarından birine dayalı bir eylem seç. (soft, greedy veya softmax).

- Harekete geç ve ödülü (r) ve yeni durumu (s’) izle.

- Gözlemlenen ödülü ve bir sonraki durum için mümkün olan maksimum ödülü kullanarak durum için Q değerini güncelle.

- Durumu yeni durumuna ayarla ve terminal durumuna ulaşana kadar işlemi tekrarla.

SARSA: Sarsa algoritması, TD öğrenme için bir politika algoritmasıdır. Sarsa ile Q öğrenme arasındaki en büyük fark, bir sonraki durum için maksimum ödülün mutlaka Q değerlerini güncellemek için kullanılmamasıdır. Bunun yerine, yeni bir eylem ve dolayısıyla ödül, orijinal eylemi belirleyen politika kullanılarak seçilir. Mevcut durumda, S bir eylem, “A” alınır ve ajan bir ödül alır, “R” ve bir sonraki durumda sona erer, “S1” ve aksiyon alır, S1'de A1. Buradan yola çıkarak (S, A, R, S1, A1) adını almıştır.

SARSA prosedürü şöyle sıralanabilir:

- İlk olarak, Q değerlerini bazı keyfi değerlere sıfırla,

- Epsilon-greedy politikasına göre bir eylem seç ve bir durumdan diğerine geç,

- Güncelleme kuralını izleyerek önceki durumdaki Q değerini güncelle.

Dünden Bugüne Yapay Zeka

KAYNAKLAR

[1] Kaelbling, L. P., Littman, M. L., and Moore, A. P. (1996). Reinforcement learning: A Survey. Journal of Artificial Intelligence Research, 237–285.

[2] Hoshino, Y., and Kamei, K. (2003). SICE 2003 Annual Conference. A proposal of reinforcement learning system to use knowledge effectively, 1582–1585. IEEE Xplore.

[3] Sutton, R. S., and Barto, A. G. (1998). Reinforcement Learning: An Introduction. Cambridge: MIT Press.

[4] Hacıbeyoğlu, M. (2006). Çoklu Etmen Mimarisi ve Takviyeli Öğrenme. Bilgisayar Mühendisliği Anabilim Dalı, Yüksek Lisans Tezi, Selçuk Üniversitesi Fen Bilimleri Enstitüsü, Konya.

[5] Szepesvari, C. (2010). Algorithms for Reinforcement Learning. Morgan & Claypool. doi: 10.2200/S00268ED1V01Y201005AIM009

[6] Kayaoğlu, T., Bilgiç, T., Özkaynak, S., Çalışır, S., ve Güçkiran, K. (2018). Pekiştirmeli Öğrenmeye Giriş Serisi-1. Web: https://medium.com/deep-learningturkiye/peki%CC%87%C5%9Fti%CC%87rmeli%CC%87-%C3%B6%C4%9Frenmeye-gi%CC%87ri%CC%87%C5%9Fseri%CC%87si%CC%87-1-8f5c35b6044

[7] Eden, T., Knittel, A., and Uffelen, R. v. (2019). Reinforcement Learning. Web: http://www.cse.unsw.edu.au/~cs9417ml/RL1/tdlearning.html

[8] Kaya, M. (2003). Çoklu Etmen Takviyeli Öğrenmeye Veri Madenciliği Tabanlı Yeni Yaklaşımlar, Doktora Tezi, Fırat Üniversitesi Fen Bilimleri Enstitüsü. Elazığ.

[9] Savaş, S. (2019), Karotis Arter Intima Media Kalınlığının Derin Öğrenme ile Sınıflandırılması, Gazi Üniversitesi Fen Bilimleri Enstitüsü Bilgisayar Mühendisliği Ana Bilim Dalı, Doktora Tezi, Ankara.

Hiç yorum yok:

Yorum Gönder